Spreche ich gerade mit einem Menschen oder mit einer Maschine? Diese Frage ist spätestens seit der massenhaften Verbreitung des KI-Chatbots ChatGPT nicht mehr so eindeutig zu beantworten. Die Grenzen verschwimmen. Auch, weil wir Menschen sie verwischen. „Wir haben schon damit begonnen, Maschinen zu vermenschlichen“, sagt Jean-Jacques Rommes. Viele Menschen interagieren mit ChatGPT, als säße ihnen ein Mensch gegenüber: ganze Sätze, höfliche Fragen, „bitte“ und „danke“. Bei einer Google-Suche ist das anders.

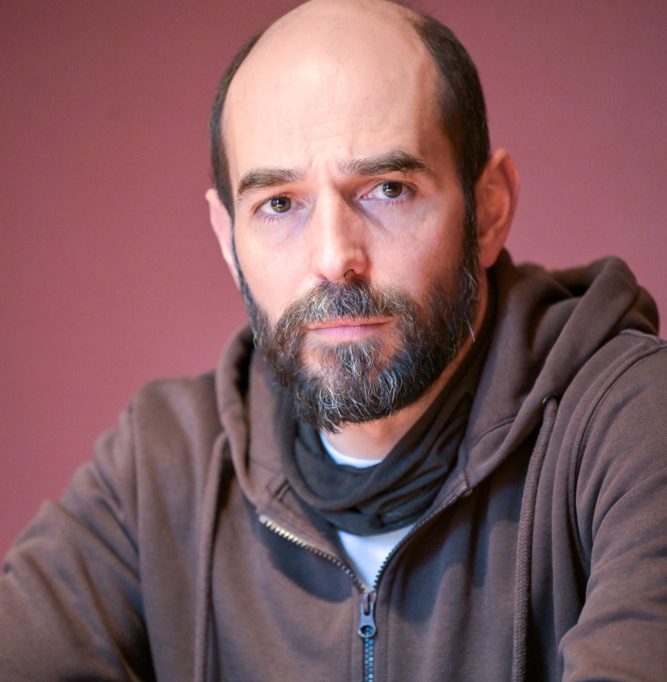

Rommes ist einer der Co-Autoren des KI-Berichts der nationalen Ethikkommission Luxemburgs. Zusammen mit anderen Experten hat er sich Gedanken darüber gemacht, was den Menschen im Zeitalter der KI eigentlich noch zum Menschen macht. Da ist zum Beispiel der Unterschied in den Informationsquellen. Menschen haben fünf Sinne. Sie sehen, hören, fühlen, schmecken und riechen ihre Umgebung. Für Maschinen besteht die Welt aus Nullen und Einsen, aus Binärcode. In der Philosophie wird dem Menschen etwas zugesprochen, was als sogenanntes phänomenales Bewusstsein oder Qualia bezeichnet wird. Ein Lebewesen, das ein phänomenales Bewusstsein besitzt, nimmt Umweltreize nicht nur auf, sondern erlebt sie auch ganz subjektiv. Sinneseindrücke wie Schmerzen, aber auch Farben haben demnach eine höchstpersönliche „Qualität“. Wie diese zustande kommt, ist ein bis heute ungelöstes Problem der Philosophie des Geistes, das sich auch mit den Mitteln der Neurowissenschaften nicht erklären lässt. Und demnach auch den Menschen von der Maschine trennt.

Lässt sich Moral programmieren?

Zugegeben, das ist eine sehr metaphysische Debatte. Aber es geht auch konkreter. Für Jean-Jacques Rommes unterscheidet sich der Mensch von der Maschine vor allem in einem zentralen Punkt: der Moral. „Der Mensch ist eine Intelligenz, die mit einem moralischen Sinn ausgestattet ist“, so Rommes. Unsere kulturellen Grundlagen identifizierten an allererster Stelle die Moral als Merkmal des Menschen, heißt es im Bericht der Ethikkommission. In der Bibel kosten Adam und Eva von der verbotenen Frucht des Baumes der Erkenntnis und können von nun an zwischen Gut und Böse unterscheiden – im Gegensatz zu allen anderen Lebensformen.

Rommes ist der Meinung, dass diese Fähigkeit den Maschinen immer fehlen wird: „Praktische Ethik ist keine Wissenschaft.“ Moral lässt sich nicht programmieren, sie braucht Gewissen und Bewusstsein. Das sehen nicht alle KI-Experten so. In den vergangenen Jahren ist ein neues Forschungsgebiet entstanden: „Machine Behaviour“, Verhaltensforschung für Maschinen. Einer der weltweit führenden Wissenschaftler in diesem Bereich ist Iyad Rahwan, Direktor des Zentrums für Mensch und Maschine am Max-Planck-Institut für Bildungsforschung in Berlin und Professor für Medienkunst und Medienwissenschaft am MIT Media Lab in Boston. Sein Projekt „The Moral Machine“ ist die bislang größte Studie auf dem Gebiet der Maschinenethik.

„The Moral Machine“ basiert auf dem populären Trolley-Problem, einem moralphilosophischen Gedankenexperiment, das ein Dilemma beschreibt: Ein autonom fahrendes Auto kommt im Straßenverkehr in eine Situation, in der sich ein schwerer Unfall nicht mehr vermeiden lässt. Die KI muss entscheiden, wohin sie das Auto steuert und wer überlebt – die Insassen oder die Fußgänger. Rahwan und sein Team haben diese Situation in unterschiedlichsten Varianten erstellt, um zu untersuchen, aus welchen moralischen Gründen Menschen Entscheidungen treffen – und wie sich das je nach Kulturkreis unterscheidet. Die Ergebnisse sind faszinierend: Alle Befragten wollen möglichst viele Menschenleben retten, sie bevorzugen Kinder und diejenigen Passanten, die sich an Verkehrsregeln halten. Doch im Detail zeigt sich, dass es so etwas wie universelle, weltweit gültige Maßstäbe nicht gibt. Teilnehmer aus Frankreich retten überwiegend eher Frauen und Kinder als Männer, Japaner eher ältere Menschen. Die meisten Deutschen wollen gar nicht erst eingreifen.

Auch wenn Maschinen noch weit davon entfernt sind, so etwas wie Moral oder Bewusstsein zu haben, Rick Serrano, KI-Ethiker, nennt „The Moral Machine“ einen „Versuch, Ethik zu programmieren“. Der Philosoph will sich auf die zukünftige Entwicklung von KI nicht festlegen lassen. Auch nicht, was die Singularität angeht. Unter der sogenannten technologischen Singularität versteht man den (hypothetischen) Zeitpunkt, an dem KI die menschliche Intelligenz übertrifft. Ab diesem Zeitpunkt könnte sich KI rasant selbst verbessern und neue Erfindungen machen. Der Fortschritt wäre irreversibel, die Menschheit hätte die Kontrolle über ihre eigene Zukunft abgegeben. Viele KI-Experten tun dies als dystopisches Hirngespinst ab, andere warnen davor. Ist es wirklich ausgeschlossen, dass die Singularität eines Tages eintreten wird? „Ich weiß es nicht“, sagt Serrano und erzählt die Geschichte von Alpha Go und Lee Sedol, dem besten Go-Spieler seiner Generation.

Ein erster Funken Bewusstsein?

Go ist ein altes chinesisches Brettspiel, das als komplexestes Strategiespiel der Welt gilt – exponentiell komplexer als Schach (es heißt, es gebe mehr mögliche Positionen auf einem Go-Brett als Atome im Universum). Während der Schachcomputer Deep Blue bereits 1996 als erste Maschine den damaligen Weltmeister Garri Kasparow schlagen konnte, glaubte der Südkoreaner Lee nicht daran, gegen einen Computer verlieren zu können. „Ich dachte, dass KI eines Tages Menschen schlagen wird. Ich dachte nur, dass der Zeitpunkt noch nicht da ist.“ Im März 2016 verlor Lee 4:1 in fünf Partien gegen die KI AlphaGo (der gleichnamige Dokumentarfilm ist frei verfügbar und sehr sehenswert).

Die Niederlage war historisch. Noch interessanter aber ist die Frage nach dem Wie. Nachdem sich Lee und AlphaGo in der ersten Partie einen erbitterten aber konventionellen Kampf geliefert hatten, der mit einem Sieg der KI endete, machte die Maschine in der zweiten Partei einen Zug, der Zuschauer und Experten verblüffte. Ein Zug, den kein Mensch jemals machen würde. Die KI hatte sich von ihrem Lernmaterial emanzipiert. Ein genialer Zug. Ein Funken echter Kreativität, gar Bewusstsein?

Drei Jahre nach seiner Niederlage gegen AlphaGo beendete Lee Sedol seine Karriere. „Ich konnte das Spiel nicht mehr genießen“, sagte er damals der New York Times. „Also bin ich in Rente gegangen.“ Heute hält Lee Vorträge über KI. Er drängt andere dazu, nicht so unvorbereitet zu sein, wie er es war, und sich jetzt mit der Technologie vertraut zu machen – bevor es zu spät ist.

Eine neue Aufklärung für das KI-Zeitalter

„Die Idee einer bewussten KI ist wahrscheinlich die wichtigste Frage von allen, aber davon sind wir noch sehr weit entfernt“, sagt Jean-Jacques Rommes. Aktuell stehe die Menschheit vor einer anderen Frage: „Können die Menschen die Kontrolle behalten, in dem Sinn, dass sie bereit sind, sich der Maschine entgegenzustellen, ihr zu widersprechen?“ Ein wichtiger Punkt, vor allem in Hinblick auf automatisierte Entscheidungssysteme, die schon heute massenhaft im Alltag eingesetzt werden – von der Kreditvergabe bis zur Musikempfehlung.

Im gesellschaftlichen Umgang mit Social Media habe die Menschheit es nicht geschafft, die Kontrolle zu behalten, so Rommes. Die Radikalisierungsmaschinen haben sich verselbstständigt. Mit KI dürfe dieser Fehler nicht noch einmal geschehen. Rommes plädiert für eine Renaissance des alten Leitspruchs der Aufklärung: „Sapere aude.“ Oder, wie Kant schrieb: „Habe Mut, dich deines eigenen Verstandes zu bedienen.“ Fragen stellen, skeptisch bleiben, das unterscheide Menschen von Maschinen, so Rommes. Die Kontrolle behalten, das bedeutet übersetzt auf eine konkrete politische Ebene: Regulierung. Doch das ist nicht so einfach. KI wird global entwickelt, in einem kompetitiven Umfeld. „Wir in Europa können nicht kontrollieren, was in den USA, in Israel oder in China passiert.“

Mehr zu den Regulierungsbemühungen der EU im dritten und letzten Teil.

Sie müssen angemeldet sein um kommentieren zu können